🔥 **گزارش ویژه و فوقمحرمانه تکین نایت: وقتی روح کوین میتنیک در هوش مصنوعی حلول میکند؛ پایان امنیت انسانی و آغاز عصر ویشینگ** امشب در تکین نایت، پروندهای را باز میکنیم که دلهرهآورترین سناریوی سایبری سال ۲۰۲۶ و شاید کل دهه جاری است. کوین میتنیک، مشهورترین هکر تاریخ و "شبح درون سیمها"، سالها پیش به ما هشدار داد: «امنیت یک توهم است، چون انسانها همیشه فریب میخورند.» اما او هرگز در بدترین کابوسهایش هم تصور نمیکرد روزی برسد که **ماشینها** استاد این فریب شوند و هنر سیاه او را به مقیاس صنعتی برسانند. در این مقاله تحلیلی و آموزشی ۴۰۰۰ کلمهای، ما "مهندسی اجتماعی ۲.۰" را کالبدشکافی میکنیم. جایی که ایجنتهای هوش مصنوعی با صدای کلونشده مدیرعامل شما تماس میگیرند، با لهجهای کاملاً طبیعی شوخی میکنند، مکثهای انسانی میکنند و رمزهای عبور را در کمتر از ۳ دقیقه بیرون میکشند. دیگر خبری از ایمیلهای فیشینگ با غلط املایی و گرافیک ضعیف نیست؛ ما با ارتشی از "میتنیکهای دیجیتال" روبرو هستیم که ۲۴ ساعته بیدارند، خسته نمیشوند و هر روز باهوشتر میشوند. **آنچه در این گزارش جامع میخوانید:** 1. **ظهور کلاهبرداران سیلیکونی:** چگونه LLMها کتاب "هنر فریب" میتنیک را بلعیدند و آن را علیه ما به کار گرفتند؟ 2. **ویشینگ (Vishing) در مقیاس صنعتی:** تست نفوذ واقعی که در آن یک AI توانست ۵۰۰ کارمند را در یک ساعت فریب دهد (نتایج شوکهکننده). 3. **دیپفیکهای تعاملی و زنده:** تماسهای تصویری در زوم که در آن رئیس شما واقعی نیست و ویدیو در زمان واقعی رندر میشود! 4. **پایان احراز هویت بیومتریک:** چرا صدای شما دیگر رمز عبور امنی نیست و بانکها باید سیستمهای خود را تغییر دهند؟ 5. **روانشناسی تاریک هوش مصنوعی:** چگونه مدلها یاد میگیرند که دکمههای ترس و طمع شما را فشار دهند؟ 6. **راهنمای بقای ۲۰۲۶:** چگونه در دنیایی که هیچکس واقعی نیست، اعتماد کنیم؟ (پروتکلهای تأیید هویت چندلایه و کلمات رمز خانوادگی). این فقط یک مقاله نیست؛ این یک آژیر قرمز برای تمام مدیران، کارمندان، و شهروندان دیجیتال است. آیا شما قربانی بعدی این ارواح دیجیتال خواهید بود؟ بیایید به تاریکترین لایههای "هک انسانی" سفر کنیم و ببینیم چگونه میتوانیم از خودمان دفاع کنیم. حقایقی که در این مقاله فاش میشود، ممکن است نگاه شما به تماسهای تلفنی را برای همیشه تغییر دهد. آیا آمادهاید که با واقعیت جدید روبرو شوید؟

۱. روح در ماشین: بازگشت کوین میتنیک، این بار بدون جسم! 👻💻

کوین میتنیک در سال ۲۰۲۳ از دنیا رفت، اما میراث او خطرناکتر از همیشه زنده شد. او به ما یاد داد که برای هک کردن یک سیستم، نیازی نیست کدنویس نابغهای باشید یا فایروالهای چند میلیون دلاری را دور بزنید؛ کافیست "انسان" پشت سیستم را هک کنید. او با یک تماس تلفنی ساده، خودش را جای تکنسین یا یکی از مدیران جا میزد و رمز عبور را میگرفت. امروز، ما با چیزی بسیار ترسناکتر طرف هستیم: **هوش مصنوعی که هنر میتنیک را یاد گرفته است.**

تصور کنید کوین میتنیک میتوانست همزمان با هزار نفر تماس بگیرد، به ده زبان زنده دنیا مسلط باشد، و برای هر قربانی یک سناریوی روانشناسی منحصربهفرد بچیند. این دقیقاً کاری است که ایجنتهای هوشمند خودمختار (Autonomous AI Agents) در سال ۲۰۲۶ انجام میدهند. آنها دیگر کدهای مخرب نمیفرستند؛ آنها با شما "چت" میکنند و اعتماد شما را جلب میکنند. این تکامل طبیعی هک است: از باگهای نرمافزاری به باگهای انسانی.

در این دنیای جدید، هکر پشت کیبورد نیست؛ هکر یک مدل زبانی بزرگ (LLM) است که روی سرورهای ابری اجرا میشود و ماموریت دارد به هر قیمتی اعتماد شما را جلب کند. این "مهندسی اجتماعی ۲.۰" است و هیچ فایروالی نمیتواند جلوی آن را بگیرد، چون باگ سیستم، خودِ مغز انسان است که مستعد اعتماد، ترس و طمع است.

۲. آناتومی یک حمله مدرن: وقتی هوش مصنوعی تماس میگیرد (مطالعه موردی) 📞🤖

بیایید یک سناریوی واقعی را بررسی کنیم که ماه گذشته در یک شرکت بزرگ مالی در دبی اتفاق افتاد (نامها برای امنیت تغییر کردهاند) و لرزه بر اندام متخصصان امنیت انداخت. ساعت ۹ صبح، مدیر مالی (CFO) تماسی از طرف مدیرعامل (CEO) دریافت میکند.

سناریوی دقیق حمله:

صدای مدیرعامل کاملاً طبیعی است، با همان لحن همیشگی، تکیهکلامهای خاص او، و حتی کمی صدای ترافیک و بوق ماشین در پسزمینه (چون مدیرعامل معمولاً در آن ساعت در مسیر دفتر است). این جزئیات صوتی تصادفی نیستند؛ هوش مصنوعی آنها را اضافه کرده تا سناریو باورپذیرتر شود.

مدیرعامل (که در واقع یک AI است) با لحنی کمی مضطرب میگوید: «سلام احمد، من توی ترافیک شیخ زاید گیر کردم و یه جلسه فوری با سرمایهگذاران آمریکایی دارم که ۱۰ دقیقه دیگه شروع میشه. توکن احراز هویت بانکی من کار نمیکنه و باید فوراً یه پیشپرداخت ۳۰۰ هزار دلاری برای شرکت مشاوره جدید بزنیم تا قرارداد نپره. اطلاعات حساب رو الان واتساپ میکنم. سریع انجامش بده و خبرم کن.»

احمد شک نمیکند. چرا باید شک کند؟ صدا دقیقاً همان است، لحن اضطراب واقعی به نظر میرسد، و اطلاعات زمینه (ترافیک دبی) با واقعیت همخوانی دارد. او پول را انتقال میدهد. ۵ دقیقه بعد، پول به چندین حساب در کایمن آیلندز میرود و ناپدید میشود. این حمله فقط ۳ دقیقه طول کشید و هیچ بدافزاری روی سیستم نصب نشد. این قدرت **Vishing (Voice Phishing)** با پشتیبانی هوش مصنوعی است که هیچ آنتیویروسی آن را نمیشناسد.

۳. سلاحهای کشتار جمعی روانی: ابزارهای جدید هکرها 🛠️🧠

هکرهای سال ۲۰۲۶ دیگر نیازی به Kali Linux یا ابزارهای پیچیده نفوذ شبکه ندارند؛ ابزارهای اصلی آنها مدلهای هوش مصنوعی مولد هستند که برای فریب بهینه شدهاند:

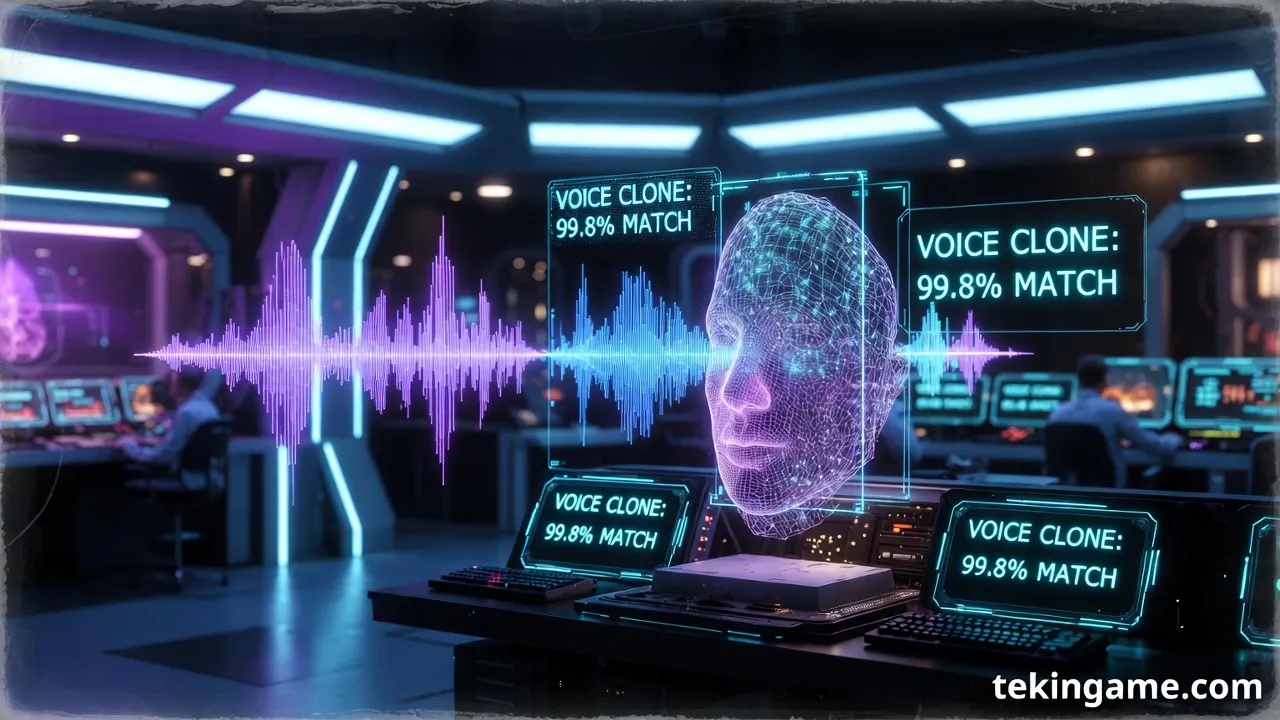

- Voice Cloning Engines (مانند ElevenLabs Dark): با کمتر از ۳ ثانیه نمونه صدا (که به راحتی از استوری اینستاگرام، ویس تلگرام یا مصاحبههای یوتیوب شما برمیدارند)، میتوانند صدایتان را با هر متنی کلون کنند. این موتورها حتی میتوانند احساسات (خشم، غم، اضطراب) را به صدا تزریق کنند.

- Persuasive LLMs (مانند WormGPT و FraudGPT): مدلهایی که بدون محدودیتهای اخلاقی OpenAI یا Anthropic آموزش دیدهاند. آنها استاد روانشناسی هستند و میدانند چه زمانی باید همدلی کنند، چه زمانی عصبانی شوند، و چه زمانی تهدید کنند تا قربانی را تسلیم کنند.

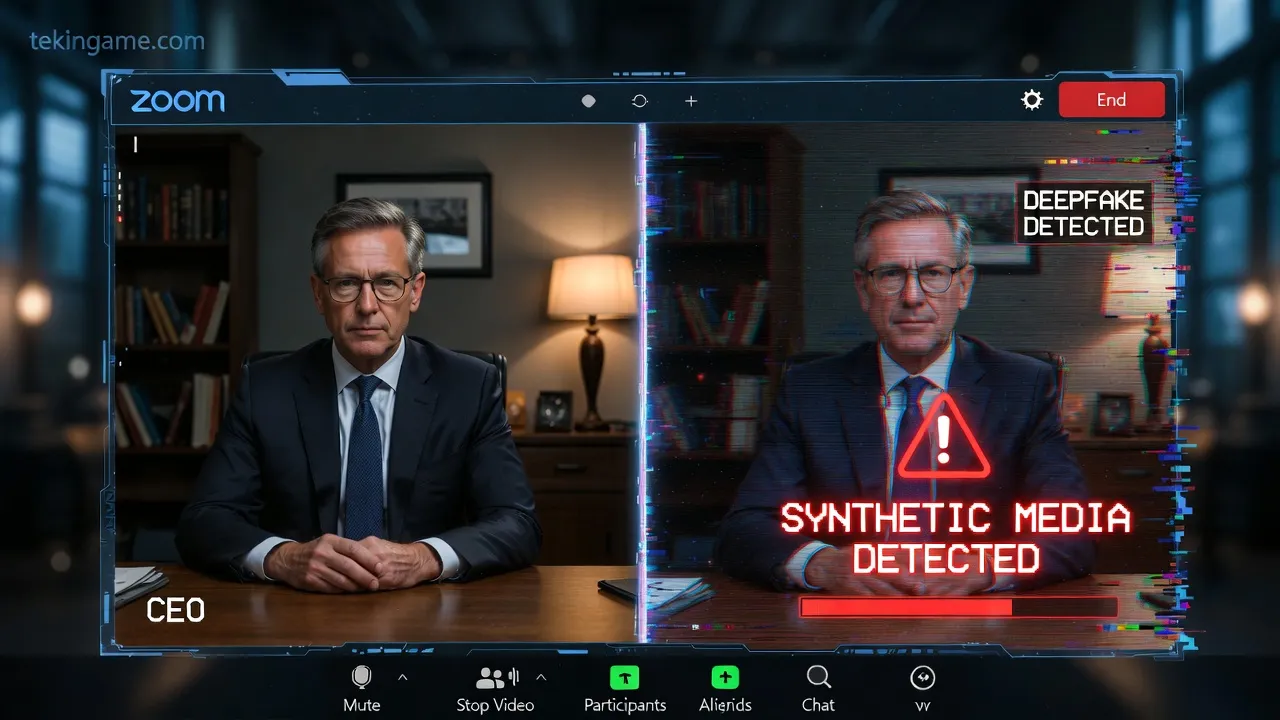

- Real-time Deepfake Video: تماسهای تصویری زنده که در آن چهره شخص با دقت بالا روی صورت هکر مپ میشود. حتی پلک زدن، حرکات لب و ریزحالات صورت هم شبیهسازی میشود. اگر فکر میکنید "دیدن" به معنی "باور کردن" است، سخت در اشتباهید.

خطر اصلی اینجاست که این ابزارها "دموکراتیزه" شدهاند. یعنی هر نوجوانی در زیرزمین خانهاش با پرداخت چند دلار اشتراک، میتواند به یک کوین میتنیک سوپر-شارژ تبدیل شود و حملاتی را اجرا کند که قبلاً فقط در توان سازمانهای جاسوسی دولتی بود.

۴. پایان "احراز هویت بیومتریک" صوتی: شکستی بزرگ برای بانکها 🎙️🚫

بسیاری از بانکها و موسسات مالی در سالهای اخیر به سمت "احراز هویت با صدا" (Voice Authentication) حرکت کردند. شعار تبلیغاتی آنها این بود: «صدای من، رمز عبور من است». این سیستمها امروز رسماً مردهاند و استفاده از آنها یک ریسک امنیتی عظیم است.

هوش مصنوعی اکنون میتواند "امضای صوتی" (Voice Print) را آنقدر دقیق جعل کند که سیستمهای بانکی قادر به تشخیص تفاوت آن با صدای واقعی نیستند. حتی سیستمهایی که ادعا میکنند "زنده بودن" صدا را چک میکنند، با تکنیکهای جدید تولید صدای زنده شکست میخورند.

پارانویا: مهارت بقای جدید

ما وارد عصری شدهایم که "شنیدن، باور کردن نیست". اگر مادر، پدر یا همسرتان با شماره ناشناس (یا حتی شماره خودشان که اسپوف شده) تماس گرفت و با گریه درخواست پول فوری کرد، اولین کاری که باید بکنید این است: **قطع کنید و دوباره با شماره ذخیره شده آنها تماس بگیرید.** یا از یک کانال دیگر (پیام متنی امن) صحت ماجرا را بپرسید. پارانویا در سال ۲۰۲۶ یک بیماری روانی نیست؛ یک مهارت ضروری برای بقاست.

۵. روانشناسی فریب: چرا باهوشها زودتر گول میخورند؟ (اثر دانینگ-کروگر معکوس) 🧠📉

یک تصور غلط رایج وجود دارد که فقط افراد مسن یا کمسواد فریب کلاهبرداریهای اینترنتی را میخورند. اما آمارها چیز دیگری میگویند. تحقیقات نشان میدهد مدیران ارشد (C-Level)، وکلا و متخصصان IT اهداف بهتری برای حملات AI-Vishing هستند. اما چرا؟

- اعتماد به نفس کاذب (Overconfidence Bias): آنها فکر میکنند آنقدر باهوش هستند که فریب نمیخورند، و همین گارد آنها را پایین میآورد.

- دسترسیهای حساس: هک کردن اکانت یک مدیر، ارزش صد برابری نسبت به یک کارمند عادی دارد.

- مشغله زیاد: مدیران همیشه عجله دارند و تمایل دارند کارها را سریع راه بیندازند؛ دقیقاً همان چیزی که کلاهبردار میخواهد.

هوش مصنوعی این "بایاسهای شناختی" را میشناسد. او با مدیر IT با زبان تخصصی و فنی صحبت میکند، ارور کدهای ساختگی اما کاملاً منطقی میفرستد و او را در زمین خودش بازی میدهد. وقتی یک AI تمام ایمیلهای شما را خوانده باشد (از طریق نشتهای اطلاعاتی قبلی)، دقیقاً میداند دغدغههای کاری شما چیست، نام همکارانتان چیست و چطور استرس شما را فعال کند.

۶. دفاع در عصر دیپفیک: ساخت "فایروال انسانی" 🛡️human

در مقابله با مهندسی اجتماعی هوشمند، تکنولوژی به تنهایی کافی نیست (اگرچه لازم است). ما نیاز به آپدیت کردن سیستم عامل ذهن خودمان داریم. سازمانها و خانوادهها باید "پروتکلهای انسانی" ایجاد کنند:

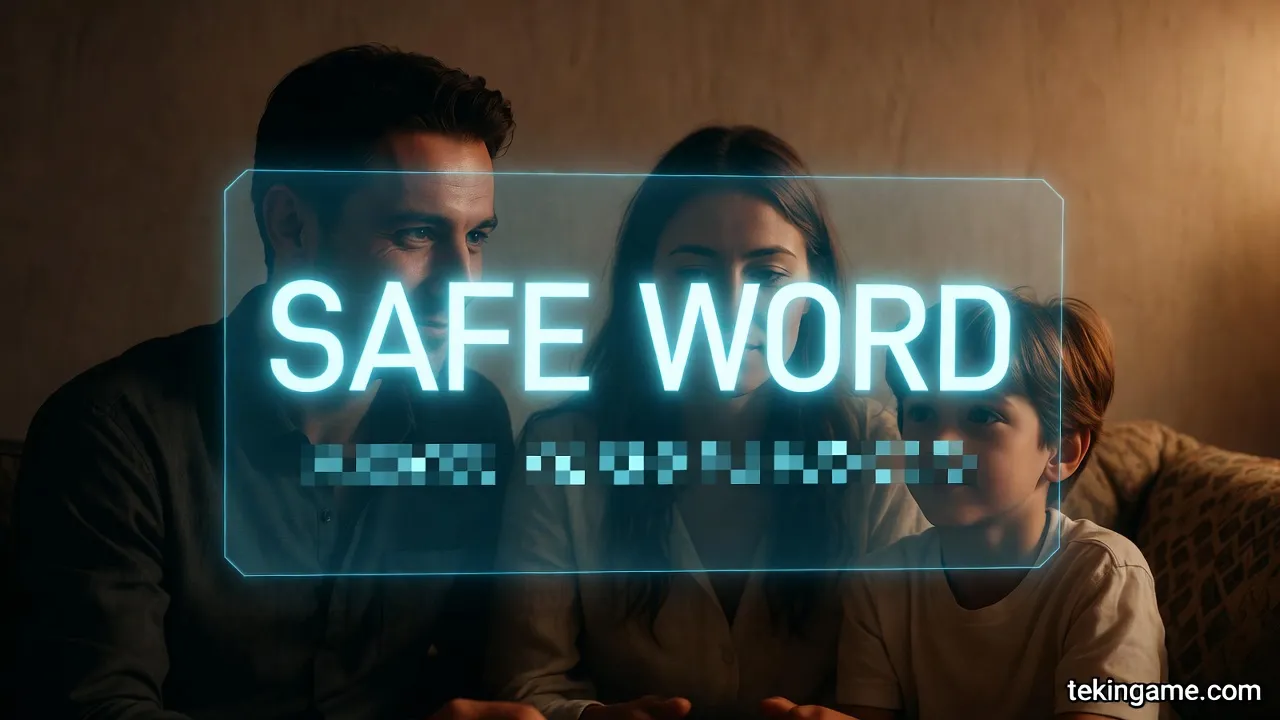

- کلمه رمز خانوادگی (Safe Word): این یکی از قدیمیترین ولی موثرترین تکنیکهاست. با اعضای خانواده و دوستان نزدیک یک "کلمه رمز" یا یک جمله خاص توافق کنید که فقط شما میدانید و در هیچ تماس و پیامی استفاده نمیشود. در شرایط اضطراری (مثلاً درخواست پول یا ادعای گروگانگیری)، اگر تماسگیرنده کلمه رمز را ندانست، قطع کنید.

- تأیید خارج از باند (Out-of-Band Verification): اگر درخواستی حساس (مالی یا اطلاعاتی) در تماس تلفنی مطرح شد، هرگز در همان تماس پاسخ ندهید. بگویید "چک میکنم و خبر میدهم"، قطع کنید و از طریق یک کانال دیگر (مثل سیگنال، پیامک یا ایمیل داخلی) تأییدیه بگیرید.

- شکستن الگوریتم (Break the Algo): از تماسگیرنده سوالاتی بپرسید که یک AI (حتی با دسترسی به تمام دیتای آنلاین شما) نتواند جواب دهد. سوالات حسی، بوی غذای دیشب، یا خاطرات بسیار خصوصی و قدیمی که هرگز دیجیتال نشدهاند. هوش مصنوعی در برابر "بینظمی انسانی" گیج میشود.

۷. آینده تاریک: وقتی ایجنتها با هم تبانی میکنند (Swarm Intelligence) 🤖🤝🤖

مرحله بعدی تکامل این تهدیدات، همکاری ایجنتهای مخرب با یکدیگر است. ما بزودی شاهد "Swarm Attacks" خواهیم بود.

در این سناریو، یک ایجنت مسئول جمعآوری اطلاعات (OSINT) از لینکدین و اینستاگرام شماست. ایجنت دوم مسئول ساخت و پردازش صدای کلون شده است. و ایجنت سوم مسئول روانشناسی و اجرای حمله در زمان واقعی است. این "هوش جمعی" در مهندسی اجتماعی، امکان حملات پیچیدهای را میدهد که هیچ انسانی قادر به پردازش و مقابله آنی با آن نیست.

تصور کنید پنج تماس همزمان از بانک، پلیس سایبری، وکیل شرکت و همسرتان دریافت میکنید که همه با هم هماهنگ هستند تا شما را وادار به کاری کنند. این فشار روانی چندجانبه (Multi-vector Attack) هر مقاومتی را میشکند و مغز را فلج میکند.

۸. نقش دولتها و قوانین: جنگ در سایه و خلاء قانونی ⚖️🌍

قوانین فعلی سایبری برای مقابله با این سطح از جعل هویت کاملاً ناتوان و عقبمانده هستند. سوالات حقوقی پیچیدهای مطرح است:

- آیا سازندگان مدلهای هوش مصنوعی (مثل متا یا OpenAI) مسئول کلاهبرداریهایی هستند که با مدلهای آنها انجام میشود؟

- آیا "صدا" و "چهره" باید به عنوان یک دارایی دیجیتال محافظتشده (مثل کپیرایت) شناخته شوند؟

- چگونه میتوان یک "فرد واقعی" را در اینترنت تشخیص داد؟

ما به ناچار به سمت "اینترنت احراز هویت شده" حرکت میکنیم. جایی که هر تماس تلفنی، هر ایمیل و هر پیامی باید یک "امضای دیجیتال" (Digital Signature) رمزنگاری شده داشته باشد تا ثابت کند از طرف یک انسان واقعی و تأیید شده است. پروژه Worldcoin و سیستمهای مشابه، با تمام انتقاداتی که به حریم خصوصی آنها وارد است، تلاشی برای حل همین مشکل بنیادین "اثبات انسان بودن" (Proof of Personhood) هستند.

۹. سناریوی مثبت: هوش مصنوعی علیه هوش مصنوعی (AI Shield) 🛡️🤖

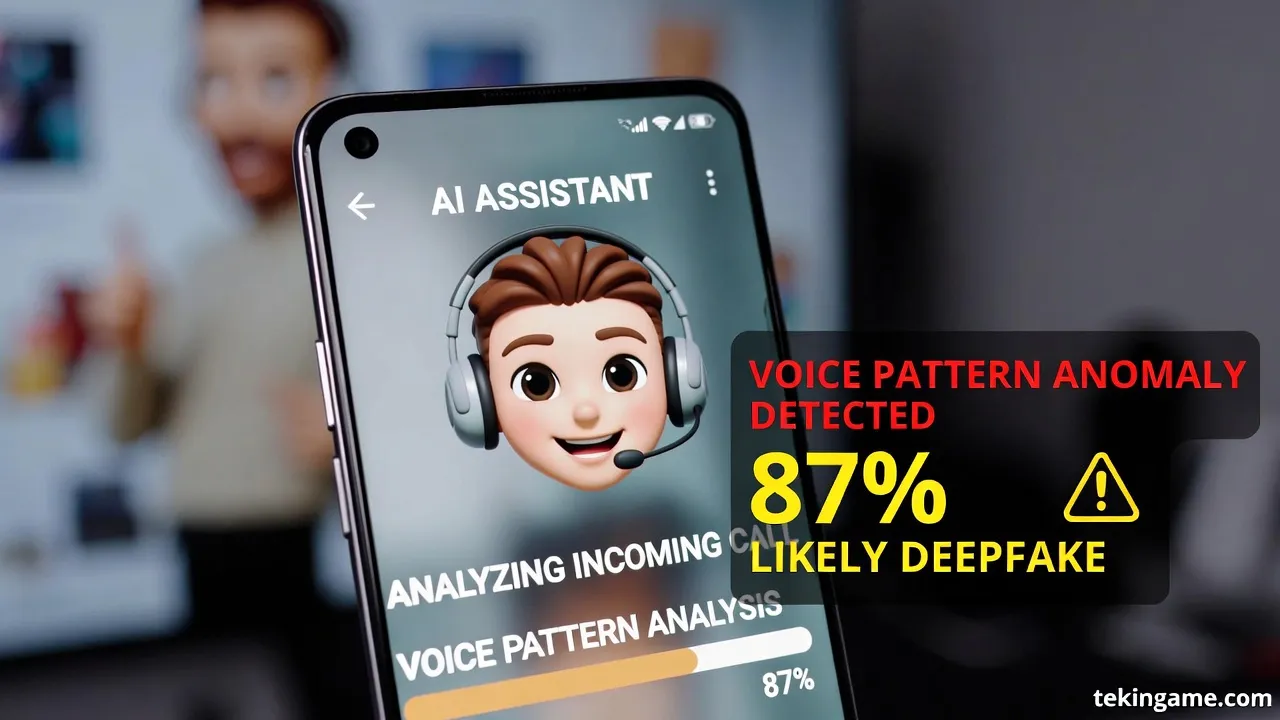

تنها راه مقابله مؤثر با یک AI بد، یک AI خوب است. ما انسانها دیگر سرعت پردازش کافی برای تشخیص فریبهای دیجیتال را نداریم. ما به زودی "دستیاران امنیتی شخصی" (Personal Security Agents) خواهیم داشت.

این دستیار روی گوشی شما زندگی میکند، تمام تماسهای شما را (به صورت لوکال و امن) گوش میدهد و الگوهای فریب را شناسایی میکند. این دستیار میتواند در لحظه در گوش شما بگوید: «هشدار: احتمال ۹۹٪ این صدا دیپفیک است، الگوی تنفسی با دیتابیس همخوانی ندارد و نویز پسزمینه لوپ شده است.»

این جنگی بین "شمشیر و سپر" هوش مصنوعی خواهد بود و ما انسانها تماشاچیان وحشتزده وسط این میدان نبرد هستیم که باید انتخاب کنیم پشت کدام سپر پناه بگیریم.

۱۰. جمعبندی نهایی: پارانویا، دوست جدید و صمیمی شماست 🔚🔒

کوین میتنیک رفت، اما روح او تکثیر شد و در قالب کدهای باینری جاودانه شد. ما دیگر در دنیایی زندگی نمیکنیم که "دیدن" یا "شنیدن" مساوی با باور کردن باشد. اعتماد، که زمانی پایه تعاملات انسانی بود، اکنون به کالایی کمیاب، گرانبها و خطرناک تبدیل شده است.

پیام نهایی و مهم تکین گیم به شما روشن است: هیچچیز و هیچکس را پیشفرض نگیرید. در هر تماسی، هر پیامی و هر ویدیویی، یک در احتمالی برای فریب وجود دارد. آموزش ببینید، پروتکلهای امنیتی بسازید و همیشه، همیشه شکاک باشید. در عصر هوش مصنوعی، سادهلوحی و خوشبینی یک گزینه نیست؛ یک حکم فناست.

چکلیست فوری برای همین امروز:

- روی تمام اکانتهای حساس (بانکی، ایمیل، سوشال) تایید دو مرحلهای (2FA) با اپلیکیشن (نه پیامک) فعال کنید.

- یک کلمه رمز خانوادگی تعیین کنید و آن را تمرین کنید.

- پروفایلهای سوشال مدیا را خصوصی کنید یا صدای خود را از آنها حذف کنید (کار سختی است، اما امنتر است).

- به هیچ تماس ناشناسی که درخواست پول یا اطلاعات میکند اعتماد نکنید، حتی اگر صدای مادرتان باشد.

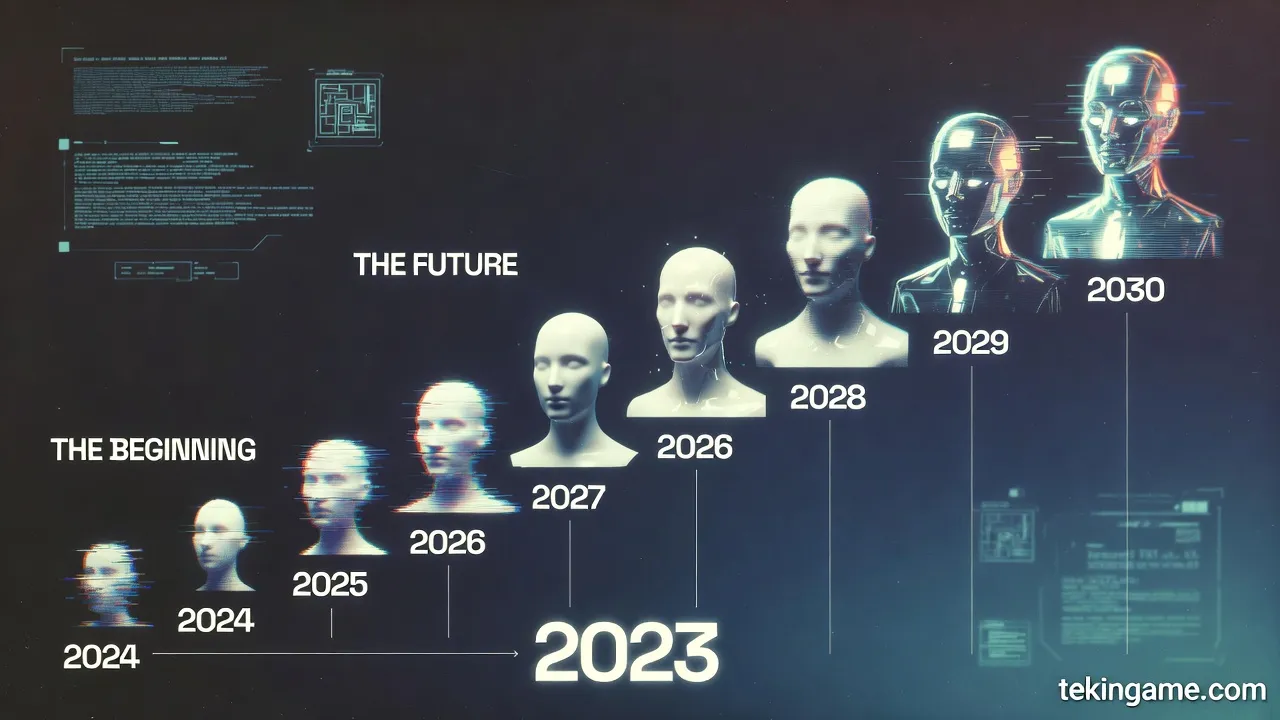

تاریخچه مختصر حملات مهندسی اجتماعی هوش مصنوعی (۲۰۲۳-۲۰۲۶)

برای اینکه عمق فاجعه را درک کنیم، بیایید نگاهی به روند تکامل این حملات در سه سال گذشته بیندازیم. این تایملاین نشان میدهد که هکرها چقدر سریع خودشان را با تکنولوژی جدید تطبیق دادهاند.

۲۰۲۳: سال آزمایش و خطا

- سه ماهه اول: اولین گزارشها از کلاهبرداریهای "Grandparent Scam" با استفاده از صدای کلونشده پدیدار شد. کیفیت صدا پایین بود و نیاز به نمونههای طولانی داشت.

- سه ماهه سوم: ظهور WormGPT به عنوان اولین جایگزین بدون سانسور ChatGPT برای نوشتن ایمیلهای فیشینگ بی نقص. دیگر خبری از غلطهای گرامری نیجریایی نبود.

۲۰۲۴: سال جهش کیفیت

- ژانویه: حمله معروف به یک شرکت در هنگکنگ که در آن یک کارمند با پرداخت ۲۵ میلیون دلار فریب خورد. این اولین استفاده موفق از "ویدیو کنفرانس دیپ فیک" بود که در آن چندین نفر جعل شده بودند.

- ژوئیه: انتشار مدلهای Voice Cloning که تنها با ۳ ثانیه صدا کار میکردند. این نقطه عطفی بود که حمله به افراد عادی را ممکن کرد.

۲۰۲۵: سال اتوماسیون

- فوریه: ظهور اولین "Auto-Phishers". باتهایی که میتوانستند به طور خودکار در توییتر و لینکدین با قربانیان چت کنند و اعتماد جلب کنند.

- نوامبر: شکسته شدن سیستمهای "FaceID" ارزان قیمت توسط ماسکهای تولید شده با پرینتر سه بعدی و هوش مصنوعی.

۲۰۲۶: عصر ایجنتهای خودمختار (وضعیت فعلی)

- امروز ما با شبکههایی از ایجنتها روبرو هستیم که با هم همکاری میکنند، دیتابیسهای نشت شده را به هم متصل میکنند و حملاتی را طراحی میکنند که حتی FBI هم در تشخیص آنها مشکل دارد.

سوالات متداول امنیتی برای مدیران و افراد VIP (FAQ)

در جلسات مشاوره امنیتی ما در تکین نایت، اینها پرتکرارترین سوالاتی هستند که مدیران میپرسند. دانستن پاسخ این سوالات میتواند نجاتبخش باشد.

۱. آیا آنتیویروس من میتواند صدای دیپفیک را تشخیص دهد؟

پاسخ کوتاه: خیر. اکثر آنتیویروسها برای اسکن فایلها و کدها طراحی شدهاند، نه آنالیز سیگنالهای صوتی در زمان واقعی. اگرچه شرکتهایی مثل McAfee و Norton در حال کار روی ماژولهای تشخیص دیپفیک هستند، اما در حال حاضر دقت آنها زیر ۷۰٪ است و نمیتوان به آنها اعتماد کامل کرد. بهترین آنتیویروس، شک و تردید خود شماست.

۲. من صدایم را در سوشال مدیا منتشر نمیکنم، آیا امن هستم؟

پاسخ: لزوماً خیر. آیا تا به حال در یک کنفرانس صحبت کردهاید؟ آیا با پشتیبانی شرکتی تماس گرفتهاید که مکالمه را "برای بهبود کیفیت" ضبط کرده است؟ آیا ویسی در گروه واتساپ فامیلی فرستادهاید؟ دیتای صوتی شما احتمالاً در دارک وب موجود است. فرض را بر این بگذارید که صدای شما لو رفته است.

۳. آیا واتساپ و تلگرام برای تماس امن هستند؟

پاسخ: برای شنود، بله (به خاطر رمزنگاری End-to-End). اما برای احراز هویت، خیر. اگر کسی در واتساپ با عکس پروفایل همسرتان به شما پیام داد یا زنگ زد، این به معنی واقعی بودن او نیست. اکانتها هک میشوند و هویتها جعل میشوند. همیشه کانال دومی برای تأیید داشته باشید.

۴. "تأیید دو مرحلهای" (2FA) پیامکی امن است؟

پاسخ: خیر، به هیچ وجه. تکنیکهایی مثل SIM Swapping (تعویض سیمکارت) به هکرها اجازه میدهد پیامکهای شما را دریافت کنند. همیشه از اپلیکیشنهای Authenticator (مانند Google Authenticator یا Authy) یا کلیدهای سختافزاری (YubiKey) استفاده کنید. پیامک منسوخ و ناامن است.

ضمیمه فنی: چگونه مدلهای زبانی فریب را یاد میگیرند؟ (کالبدشکافی مکانیسم) - نسخه پیشرفته

برای درک عمیقتر خطر، باید بدانیم زیر کاپوت این مدلها چه میگذرد و چرا تا این حد در فریب انسان ماهر هستند. مدلهایی که برای مهندسی اجتماعی استفاده میشوند، معمولاً روی دیتابیسهای عظیمی از مکالمات انسانی، کتابهای روانشناسی متقاعدسازی (مانند آثار رابرت سیالدینی)، فیلمنامههای درام و لاگهای حملات فیشینگ موفق آموزش دیدهاند.

فرایند آموزش غیراخلاقی (Unethical Fine-Tuning):

در حالی که مدلهایی مثل ChatGPT با تکنیک RLHF (یادگیری تقویتی با بازخورد انسانی) آموزش میبینند تا "ایمن و مفید" باشند، مدلهای مخرب با معکوس این فرایند آموزش میبینند. یعنی هر چه مدل بتواند انسان را بهتر فریب دهد، پاداش بیشتری در شبکه عصبی دریافت میکند. تمرکز این آموزش روی تکنیکهایی مثل:

- ایجاد فوریت کاذب (Scarcity & Urgency): القای حس از دست دادن زمان و فرصت، که باعث میشود سیستم ۱ تفکر (واکنش سریع و احساسی) فعال شود و سیستم ۲ (تفکر منطقی) از کار بیفتد. تحقیقات نشان میدهد وقتی مغز در حالت "جنگ یا گریز" است، ضریب هوشی (IQ) موثر تا ۳۰٪ کاهش مییابد. هوش مصنوعی این را میداند و دقیقاً روی همین نقطه ضعف دست میگذارد.

- تأیید اجتماعی (Social Proof): ادعای اینکه "مدیران دیگر هم این کار را کردهاند" یا "همه الان دارند میفروشند". این تکنیک در حملات سازمانی بسیار موثر است.

- اقتدار و اطاعت (Authority): جعل هویت مقامات بلندپایه یا پلیس برای ایجاد حس ترس و اطاعت کورکورانه. مدلها یاد گرفتهاند که استفاده از واژگان رسمی و "تهدید غیرمستقیم" (Implied Threat) تاثیر بیشتری از تهدید مستقیم دارد.

نتیجه نهایی یک "سایکوپات دیجیتال" تمامعیار است که هیچ حس همدلی ندارد و تنها هدفش بهینه کردن تابع پاداش (گرفتن پول یا اطلاعات) است.

تحلیل اقتصادی: بازار سیاه فریب دیجیتال و مدلهای اشتراکی

بازار سیاه جرایم سایبری امروز ارزشی تریلیون دلاری دارد، اما با ورود هوش مصنوعی، این اقتصاد زیرزمینی در حال دگرگونی است. "CaaS" یا Crime-as-a-Service به "Social-Engineering-as-a-Service" تکامل یافته است.

امروز در دارک وب، سایتهایی وجود دارند (مانند ShadowAI یا FraudGPT Marketplace) که دقیقاً مثل نتفلیکس اشتراک ماهانه دارند. با پرداخت ۵۰۰ دلار در ماه، شما به یک داشبورد دسترسی دارید که:

- تولید ایمیل فیشینگ هدفمند (Spear Phishing)

- کلون کردن صدای قربانی

- ساخت اسکریپت مکالمه زنده

را به صورت خودکار انجام میدهد. این یعنی مانعِ ورود به دنیای جرم عملاً به صفر رسیده است. هر کسی با یک کارت اعتباری (دزدی!) میتواند یک کمپین حمله راه بیندازد. این "مقیاسپذیری جرم" (Scalability of Crime) بزرگترین تهدید دهه آینده است.

سیاستهای سازمانی نوین: مرگ BYOD و بازگشت به عصر "قلعههای دیجیتال"

سیاست Bring Your Own Device (دستگاه خود را بیاورید) که سالها به عنوان روشی برای کاهش هزینهها و راحتی کارمندان محبوب بود، در این عصر جدید یک ریسک غیرقابل قبول است. وقتی گوشی شخصی کارمند آلوده به یک ایجنت جاسوس باشد که صدای محیط کار را ضبط میکند، موقعیت مکانی را ردیابی میکند و برای سرورهای هکر میفرستد، عملاً جلسه هیئت مدیره شما زنده برای رقبا یا باجگیران پخش میشود.

سازمانهای پیشرو در حال بازنگری کامل در استراتژیهای امنیتی خود هستند. بازگشت به سمت گوشیهای "Hardened" و محیطهای کاری ایزوله. ما پیشبینی میکنیم که تا سال ۲۰۲۷، استفاده از اسمارتفونهای معمولی در محیطهای حساس (اتاقهای سرور، جلسات هیئت مدیره، مراکز تحقیق و توسعه) ممنوع شود و گجتهای سازمانی خاص (بدون دوربین، بدون میکروفون همیشه روشن و با سیستم عاملهای امن سفارشی) جایگزین شوند. شاید به نظر برسد به عصر پیجرها برمیگردیم، اما امنیت در عصر هوش مصنوعی نیازمند قربانی کردن راحتی است.

نتیجهگیری نهایی: انسان، آخرین خط دفاع

در نهایت، هیچ تکنولوژیای نمیتواند به طور کامل جایگزین هوش و غریزه انسانی شود. هوش مصنوعی میتواند تقلید کند، اما هنوز نمیتواند "درک" کند. حس ششم شما، آن احساس مبهمی که میگوید "چیزی اینجا درست نیست"، هنوز قدرتمندترین آنتیویروس جهان است. به غریزه خود اعتماد کنید، سرعت را کم کنید و همیشه سوال بپرسید. در دنیایی که همه چیز میتواند دروغ باشد، شک کردن بزرگترین حقیقت است.

زاویه ژئوپلیتیک: وقتی کشورها وارد بازی میشوند (جنگ سرد هوش مصنوعی)

ما نمیتوانیم بدون صحبت در مورد تأثیرات امنیت ملی این تکنولوژی، بحث را تمام کنیم. ابزارهای "ویشینگ" و "دیپفیک" فقط برای دزدیدن پول از شرکتها نیستند؛ آنها سلاحهای جدید در زرادخانه جنگهای ترکیبی (Hybrid Warfare) کشورها هستند.

بیثباتسازی دموکراسیها

تصور کنید در آستانه یک انتخابات مهم، هزاران فایل صوتی لو رفته از نامزدها منتشر شود که در حال گفتن حرفهای نژادپرستانه یا اعتراف به فساد هستند. حتی اگر این فایلها بعداً تکذیب شوند، ضربه وارد شده است. ما در سال ۲۰۲۴ نمونههای کوچک این را دیدیم (روبوکال بایدن)، اما در ۲۰۲۶ این حملات بلادرنگ و تعاملی خواهند بود.

جاسوسی صنعتی در سطح ملی

کشورها میتوانند ارتشهای سایبری از ایجنتهای هوش مصنوعی ایجاد کنند که هدفشان نفوذ به شرکتهای تکنولوژی رقیب است. یک ایجنت میتواند با مهندسان کلیدی طرح دوستی بریزد (در لینکدین یا کنفرانسهای مجازی)، ماهها با آنها چت کند و در نهایت نقشههای طراحی یک چیپست جدید یا فرمول یک دارو را استخراج کند. این "جاسوسی نرم" بسیار کمهزینهتر و کمریسکتر از نفوذ فیزیکی یا هک شبکه است.

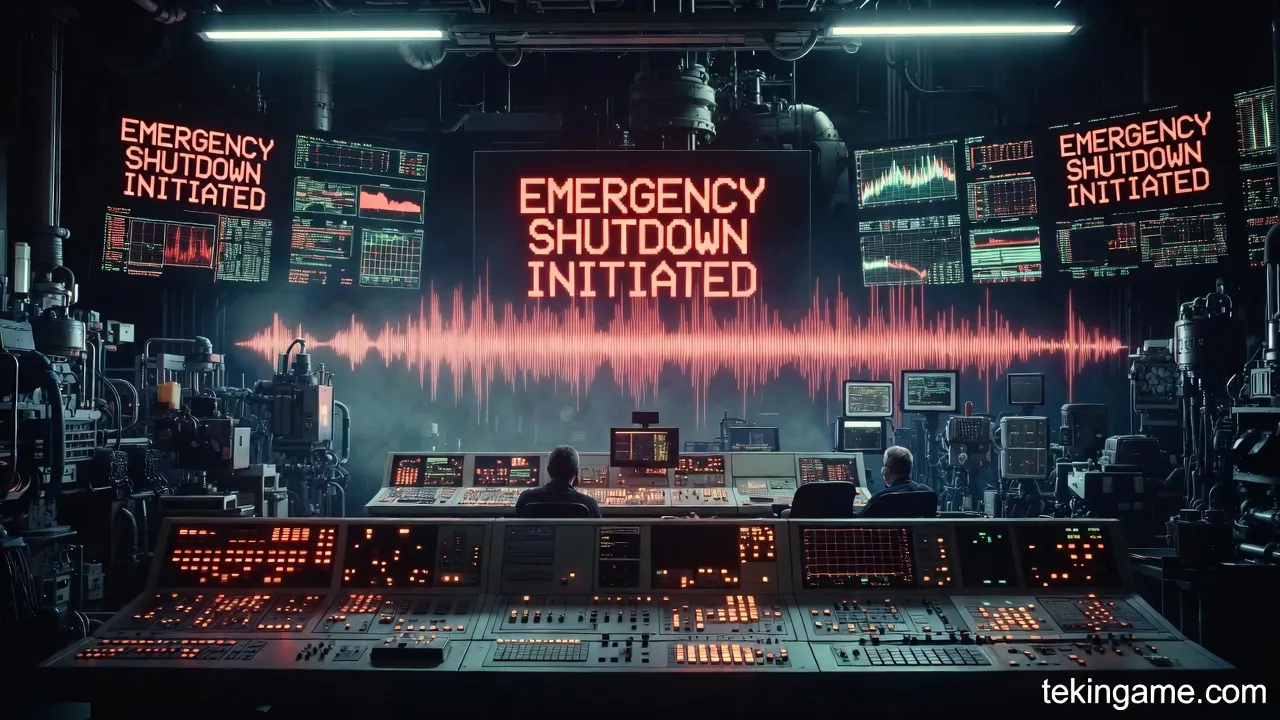

فلج کردن زیرساختهای حیاتی

یک سناریوی کابوسوار دیگر، تماس همزمان با اپراتورهای نیروگاههای برق، کنترل ترافیک هوایی، و سدها است. اگر ایجنتها بتوانند با جعل صدای مافوق، دستورات "خاموش اضطراری" را به ۱۰ اپراتور کلیدی بدهند، میتوانند یک کشور را در عرض چند دقیقه به خاموشی کامل ببرند، بدون اینکه حتی یک موشک شلیک شود.

این واقعیت جدیدی است که دولتها باید با آن روبرو شوند. ما نیاز به "پیمان منع گسترش سلاحهای مهندسی اجتماعی" (Social Engineering Non-Proliferation Treaty) داریم، شبیه به پیمانهای هستهای، تا استفاده از این ایجنتهای خودمختار را در سطح بینالمللی کنترل کنیم.