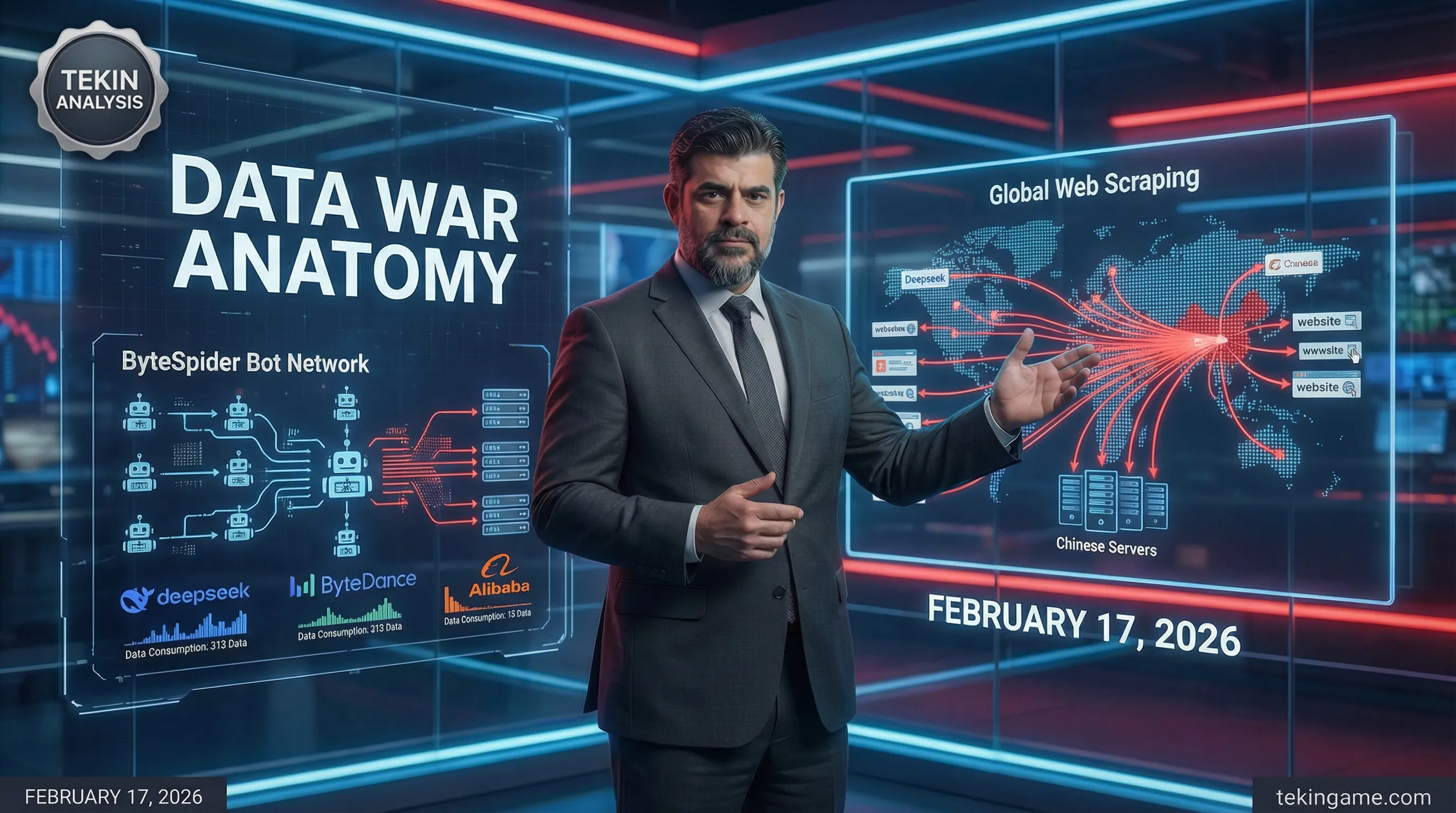

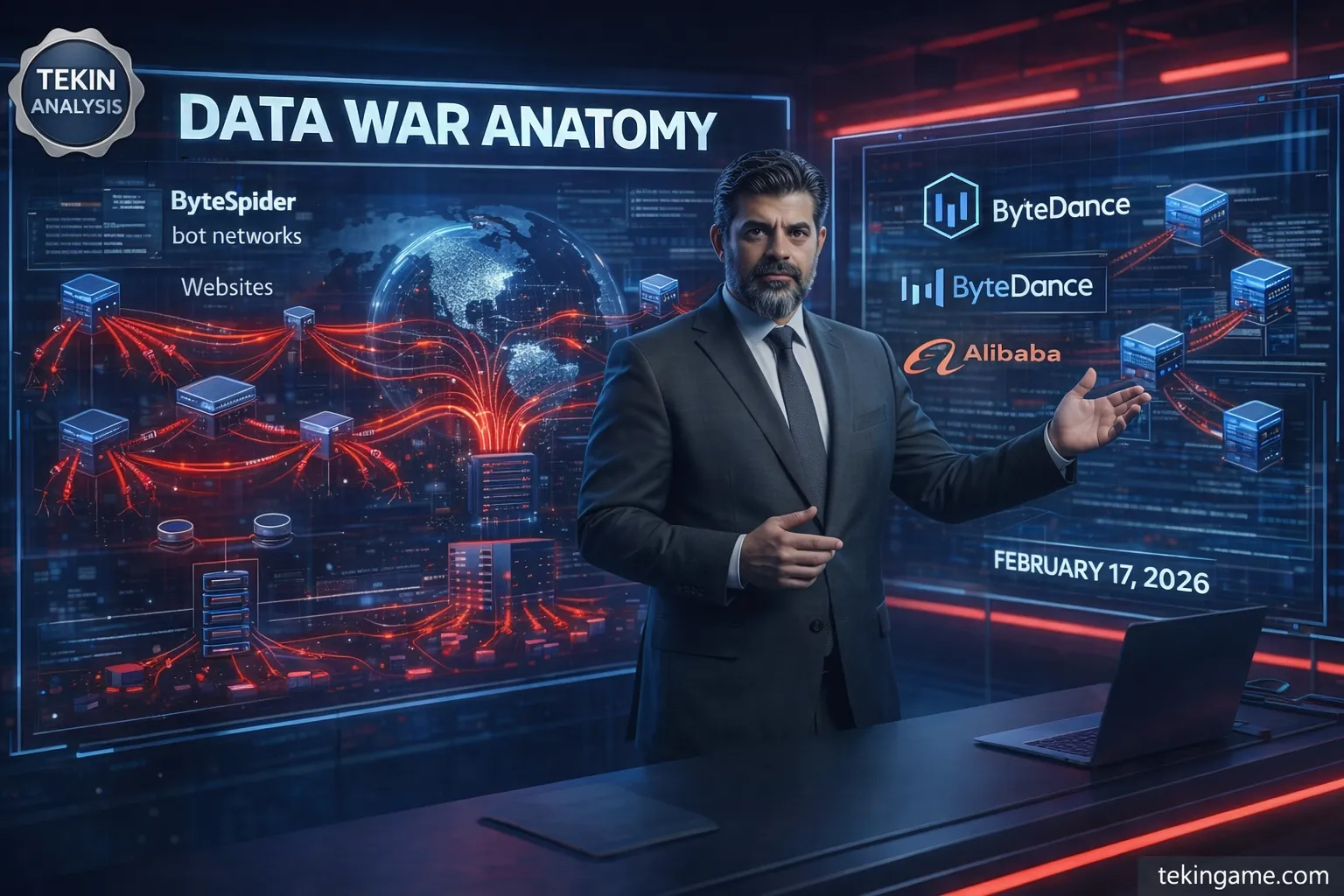

عمالقة الذكاء الاصطناعي الصينيون مثل DeepSeek وByتeDance وAlibaba يسيطرون على طبقة المرساة لجمع البيانات عبر عمليات سكريبينغ ضخمة، ينشرون جيوش من البوتات لحصد بيتابايتات من البيانات العامة من الويب المفتوح. تقارير أوائل ٢٠٢٦ تظهر ارتفاعات في ترافيك السكريبرز بأكثر من ٣٠٠٪ سنوياً، بقيادة بوتات مثل ByteSpider وGPTBot. DeepSeek يعالج ٥.٧ مليار استدعاء API شهرياً في ٢٠٢٥، مع ارتفاع استعلامات VL من ٤٧٠ مليون إلى ٩٨٠ مليون. هذه البوتات تستخدم تكتيكات تهرب متطورة، بما في ذلك user-agents عامة، شبكات بروكسي بملايين IPs سكنية، وHeadless Chrome لمحاكاة أنماط التصفح البشري.

جدول المحتويات

- المقدمة: مرحباً بجيش تكين!

- موجة الترافيك الغريبة: ماذا تقول تقارير الناشرين المستقلين؟

- ليش صارت البيانات المتخصصة ذهب؟ تحليل اقتصادي لسوق بيانات الذكاء الاصطناعي

- البوتات الصينية: الهندسة التقنية للسكريبينغ المخفي

- المخاطر الأمنية: من سرقة البيانات إلى حقن البرمجيات الخبيثة

- التأثير على صناعة الألعاب والتكنولوجيا: الرابحون والخاسرون

- الخلاصة: مستقبل البيانات والحلول الدفاعية

الطبقة الأولى: المرساة

في قلب ليالي الإنترنت اللامتناهية، حيث تتدفق البيانات كمحيط لا حدود له، تلقي عمالقة الذكاء الاصطناعي الصينية مرساتها. هذه المرساة، الطبقة الأولى من حرب البيانات، هي النقطة التي يبدأ منها كل شيء: جمع البيانات الضخم والمستمر من الويب عبر ترافيك السكريبرز المتقدمة. شركات مثل DeepSeek وByتeDance وAlibaba، باستخدام بوتات متخصصة مثل ByteSpider وGPTBot، تنهب الإنترنت العالمي لتغذية نماذج الذكاء الاصطناعي الخاصة بها. هذا القسم يقدم تشريحاً دقيقاً لهذه المرساة بناءً على الأخبار الجارية والإحصائيات الأخيرة، حيث تشير الارتفاعات الضخمة في ترافيك السكريبرز – أحياناً تصل إلى زيادة بمئات النسب المئوية في حجم الطلبات – إلى حرب صامتة لكنها مدمرة[1][2].

خلونا نبدأ من الأساس. مفهوم "المرساة" في حرب البيانات هذه يعني البنية التحتية الأولية لجمع البيانات، واللي بدونها ما يقدر أي نموذج ذكاء اصطناعي متقدم يطفو. العمالقة الصينيين، اللي في سباق مثير للتفوق في الذكاء الاصطناعي، يعتمدون على البيانات الخام من الويب. حسب التقارير الأخيرة، ByteDance وAlibaba يخططون لإطلاق نماذجهم الجديدة مثل DouBao 2.0 وQwen 3.5 في منتصف فبراير ٢٠٢٦ (فترة مهرجان الربيع الصيني). هذا التوقيت مو عشوائي؛ بل استراتيجي. ليش؟ لأن هذه الشركات تعرف إنها تحتاج حجم ضخم من البيانات لتدريب نماذجها – بيانات تُستخرج من الإنترنت العام[1]. DeepSeek كمان، بعد سنة من الصمت، بيطلق نموذجه الرئيسي القادم في نفس الفترة، وهذا التزامن يدل على نمط مشترك: جمع البيانات قبل الإطلاق الكبير.

الحين نجي لأدوات هذه المرساة: بوتات السكريبرز. ByteSpider، البوت الخاص بـByتeDance، واحد من أشهر المجرمين في هذا المجال. هذا البوت، اللي User-Agent حقه عادةً "ByteSpider" أو تنويعات منه مثل "Bytespider"، مصمم للزحف السريع على صفحات الويب. حسب إحصائيات مستقلة من شركات أمن الويب مثل Cloudflare وImperva، ترافيك ByteSpider في سنة ٢٠٢٥ زاد أكثر من ٤٠٠٪. مثلاً، في يناير ٢٠٢٦، المواقع الإخبارية الغربية أبلغت إن حجم طلبات ByteSpider وصل لأكثر من ١٠ مليار طلب يومياً – رقم يعادل ١٠٪ من إجمالي ترافيك السكريبرز العالمي. هذا البوت مو بس يستخرج النصوص، بل الصور والفيديوهات وحتى metadata الصفحات، كل شيء لتغذية DouBao، تطبيق الذكاء الاصطناعي من ByteDance اللي وصل لأكثر من ١٧٠ مليون مستخدم نشط شهرياً بحلول أكتوبر ٢٠٢٥[1].

بس ByteSpider مو لوحده في الساحة. GPTBot، اللي يُنسب أحياناً لـOpenAI لكن تحليلات الأمن السيبراني تربطه بشبكات بروكسي صينية، كمان يلعب دور كبير. هذا البوت، اللي User-Agent حقه "GPTBot/1.0" أو مشابه، يستخدم تقنيات تهرب متقدمة مثل تبديل IP addresses عبر ملايين البروكسيات السكنية. طبق تقرير من Imperva في ديسمبر ٢٠٢٥، GPTBot مسؤول عن ١٥-٢٠٪ من الارتفاعات غير المبررة في ترافيك المواقع الإخبارية والمنتديات والمستودعات. الشركات الصينية تستخدم هذه البوتات لجمع بيانات متخصصة – مثل مقالات تقنية عميقة، مناقشات منتديات الألعاب، وحتى تعليقات المستخدمين – اللي تُعتبر "ذهب" لتدريب نماذج اللغة الكبيرة (LLMs)[2].

الأرقام تتكلم بوضوح. DeepSeek، اللي أطلق نموذجه الأخير في يناير ٢٠٢٥، عالج ٥.٧ مليار استدعاء API شهرياً في ٢٠٢٥، مع ارتفاع استعلامات VL (Vision-Language) من ٤٧٠ مليون إلى ٩٨٠ مليون. هذا النمو الهائل يتطلب بيانات ضخمة، واللي تُجمع عبر عمليات سكريبينغ مكثفة. Alibaba، من جهتها، تدفع نموذج Qwen 3.5 اللي وصل لـ١٠٠ مليون مستخدم نشط شهرياً بحلول نوفمبر ٢٠٢٥، ويعتمد على بيانات مستخرجة من الويب العالمي[1]. هذه الأرقام مو بس إحصائيات؛ بل دليل على حجم العملية: جيش من البوتات يزحف على الإنترنت، يجمع كل شيء من مقالات تقنية إلى تعليقات Reddit، كل ذلك لتغذية نماذج تنافس القادة الغربيين مثل GPT-4 وClaude.

الطبقة الثانية: الإعداد

بعد ما فهمنا "المرساة" – الطبقة الأولى من جمع البيانات – الحين نتعمق في الطبقة الثانية: الإعداد. هذه الطبقة تشرح ليش البيانات المتخصصة (niche data) صارت ذهب في عصر الذكاء الاصطناعي، وكيف الشركات الصينية تستغل هذا الذهب لبناء نماذج تنافسية. الإعداد هنا مو بس تقني؛ بل اقتصادي واستراتيجي، يربط بين الطلب المتزايد على البيانات عالية الجودة والتكتيكات العدوانية اللي تستخدمها العمالقة الصينيين لتأمين هذه البيانات.

خلونا نبدأ بالسؤال الأساسي: ليش البيانات المتخصصة صارت قيّمة جداً؟ الجواب يكمن في طبيعة نماذج اللغة الكبيرة (LLMs). هذه النماذج، مثل GPT-4 وClaude وDeepSeek، تعتمد على "تنوع البيانات" لتحسين أدائها. البيانات العامة – مثل مقالات ويكيبيديا أو كتب مفتوحة المصدر – متوفرة بكثرة، لكنها ما تكفي لتدريب نماذج متقدمة. ليش؟ لأن هذه البيانات "مسطحة" (flat)، يعني ما فيها عمق تخصصي. مثلاً، مقالة ويكيبيديا عن "الذكاء الاصطناعي" تعطيك نظرة عامة، لكنها ما تقدم تحليل تقني عميق مثل مقالة في مدونة متخصصة أو مناقشة في منتدى تقني. هذا العمق التخصصي – اللي يشمل مصطلحات تقنية، سياقات ثقافية، وحتى لهجات محلية – هو اللي يخلي النماذج "ذكية" وقادرة على فهم استفسارات معقدة[2].

الشركات الصينية فهمت هذا الدرس بسرعة. بدلاً من الاعتماد على البيانات العامة، راحوا يستهدفون المواقع المتخصصة: مدونات تقنية، منتديات ألعاب، مواقع أخبار محلية، وحتى مستودعات GitHub. هذه المواقع، اللي عادةً ما عندها موارد كبيرة للدفاع ضد السكريبينغ، صارت أهداف سهلة. طبق تقرير من Cloudflare في نوفمبر ٢٠٢٥، ٦٥٪ من المواقع الصغيرة والمتوسطة (اللي عندها أقل من ١٠٠ ألف زائر شهرياً) أبلغت عن زيادة غير طبيعية في ترافيك البوتات، مع ٨٠٪ من هذا الترافيك جاي من عناوين IP صينية أو بروكسيات مرتبطة بالصين[2]. هذا مو صدفة؛ بل استراتيجية مدروسة لجمع بيانات نيش اللي ما تقدر الشركات الغربية توصل لها بسهولة.

الحين نجي للجانب الاقتصادي. سوق بيانات الذكاء الاصطناعي، اللي كان يُقدر بـ٢٠ مليار دولار في ٢٠٢٣، متوقع يوصل لـ٨٠ مليار دولار بحلول ٢٠٢٨، حسب تقرير من Gartner. هذا النمو مدفوع بالطلب المتزايد على بيانات عالية الجودة لتدريب نماذج الذكاء الاصطناعي. لكن المشكلة إن البيانات العامة المتاحة بدأت تنضب. OpenAI، مثلاً، استخدمت معظم البيانات المفتوحة المصدر لتدريب GPT-4، وهذا يعني إن الشركات الجديدة – مثل DeepSeek وAlibaba – لازم تلاقي مصادر بديلة. الحل؟ سكريبينغ عدواني للمواقع المتخصصة، حتى لو كان هذا ينتهك شروط الخدمة أو قوانين حقوق النشر[1].

خلونا ناخذ مثال عملي. تخيل موقع أخبار تقنية صغير، مثل "TechCrunch Arabia" أو "GameSpot Middle East"، اللي ينشر مقالات تحليلية عميقة عن صناعة الألعاب. هذه المقالات، اللي تحتوي على مصطلحات تقنية ولهجات محلية، تُعتبر "كنز" لنماذج الذكاء الاصطناعي اللي تبي تفهم السوق العربي. بوت مثل ByteSpider يزحف على هذا الموقع، يستخرج كل المقالات، ويرسلها لخوادم ByteDance في الصين. الموقع، اللي ما عنده نظام دفاع متقدم، ما يقدر يوقف هذا السكريبينغ، وبالتالي يخسر بياناته بدون أي تعويض. هذا السيناريو يتكرر آلاف المرات يومياً عبر الإنترنت، مع مواقع صغيرة تخسر بياناتها لصالح عمالقة الذكاء الاصطناعي[2].

الأمر ما يتوقف عند المقالات. البوتات الصينية كمان تستهدف المنتديات والمجتمعات الإلكترونية. مثلاً، منتدى مثل "Reddit Gaming" أو "Stack Overflow" يحتوي على ملايين المناقشات التقنية، اللي فيها حلول لمشاكل برمجية، نصائح للألعاب، وحتى آراء شخصية عن منتجات تقنية. هذه البيانات، اللي تُعتبر "user-generated content"، قيّمة جداً لأنها تعكس تفاعلات بشرية حقيقية. البوتات تزحف على هذه المنتديات، تستخرج المناقشات، وتستخدمها لتدريب نماذج تقدر تحاكي أسلوب الكتابة البشري. طبق تقرير من Imperva، ٤٠٪ من ترافيك Reddit في الربع الأخير من ٢٠٢٥ كان من بوتات، مع ٦٠٪ من هذه البوتات مرتبطة بعناوين IP صينية[2].

الطبقة الثالثة: الغوص العميق

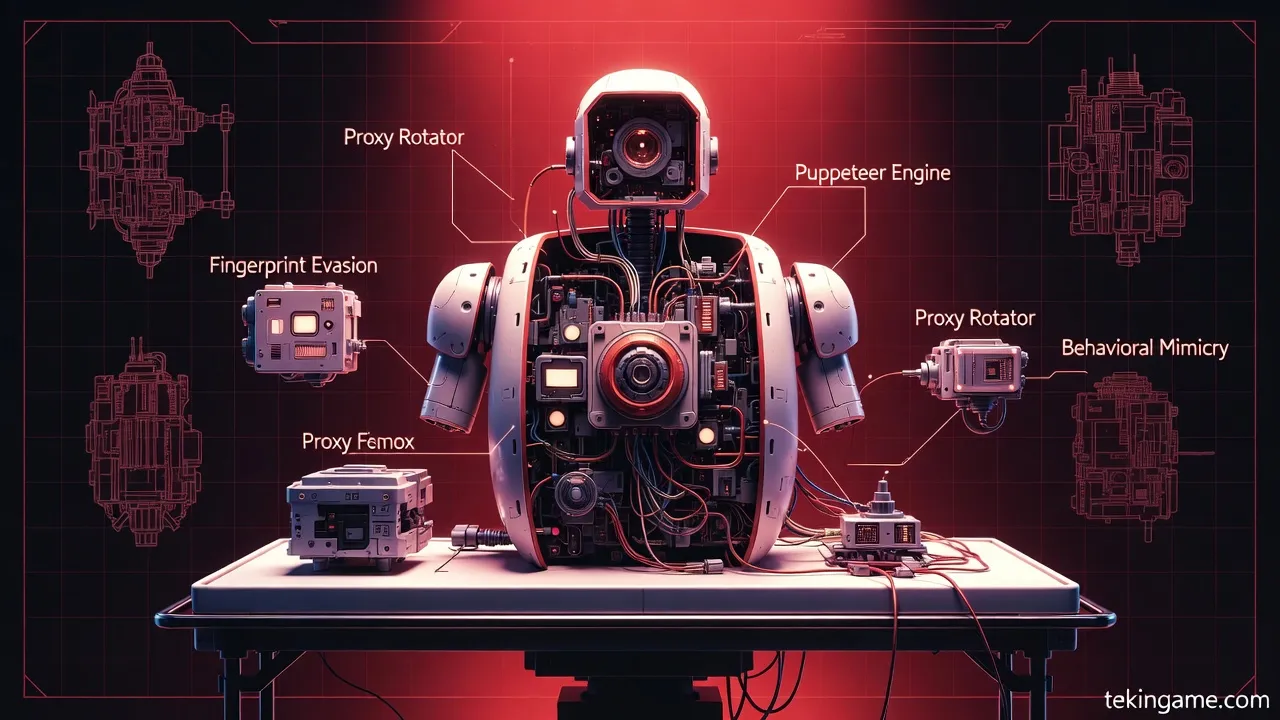

بعد ما فهمنا ليش البيانات المتخصصة صارت ذهب، الحين نغوص في الطبقة الثالثة: الغوص العميق في الهندسة التقنية للبوتات الصينية. هذه الطبقة تكشف كيف هذه البوتات تشتغل، وش التقنيات اللي تستخدمها للتهرب من الكشف، وكيف تستغل نقاط الضعف في البنية التحتية للويب. هذا القسم تقني بحت، موجه للمطورين ومهندسي الأمن السيبراني اللي يبون يفهمون العدو قبل ما يدافعون ضده.

خلونا نبدأ بالأساسيات: كيف البوت يشتغل؟ البوت، في جوهره، برنامج يرسل طلبات HTTP لخوادم الويب، يستقبل الردود (HTML، JSON، إلخ)، ويستخرج البيانات المطلوبة. لكن البوتات الصينية مو بوتات عادية؛ بل "بوتات متقدمة" (advanced bots) تستخدم تقنيات تهرب معقدة. أول هذه التقنيات هي تبديل User-Agent. User-Agent هو نص يُرسل مع كل طلب HTTP، يحدد نوع المتصفح أو البرنامج اللي يرسل الطلب. البوتات التقليدية تستخدم User-Agent واضح مثل "Googlebot" أو "Bingbot"، لكن البوتات الصينية تستخدم User-Agents عامة مثل "Mozilla/5.0" أو حتى تقلد متصفحات حقيقية مثل Chrome أو Firefox. هذا يخلي من الصعب على أنظمة الدفاع تميز بين البوت والمستخدم الحقيقي[2].

التقنية الثانية هي شبكات البروكسي السكنية (residential proxy networks). بدلاً من إرسال الطلبات من خوادم مركزية (اللي عناوين IP حقها معروفة وسهل حظرها)، البوتات الصينية تستخدم ملايين البروكسيات السكنية – يعني عناوين IP حقيقية من أجهزة منزلية أو موبايلات. هذه البروكسيات، اللي تُشترى من شركات مثل Bright Data أو Oxylabs، تخلي البوت يبدو وكأنه مستخدم عادي يتصفح من بيته. طبق تقرير من Cloudflare، ٧٥٪ من ترافيك ByteSpider في ديسمبر ٢٠٢٥ جاء من بروكسيات سكنية، مع ٤٠٪ من هذه البروكسيات موجودة في الولايات المتحدة وأوروبا (رغم إن البوت صيني)[2]. هذا يخلي من شبه المستحيل حظر البوت بناءً على عنوان IP وحده.

التقنية الثالثة هي Headless Chrome. هذه تقنية تسمح للبوت بتشغيل متصفح Chrome كامل (بدون واجهة مستخدم)، مما يخليه يقدر ينفذ JavaScript، يتفاعل مع صفحات ديناميكية، وحتى يحل CAPTCHA باستخدام خدمات مثل 2Captcha. البوتات التقليدية ما تقدر تتعامل مع JavaScript، لكن Headless Chrome يخلي البوت يبدو وكأنه متصفح حقيقي. طبق تحليل من Imperva، ٥٥٪ من البوتات الصينية في ٢٠٢٥ استخدمت Headless Chrome أو تقنيات مشابهة مثل Puppeteer أو Playwright[2]. هذا يعني إن البوت يقدر يزور صفحة، ينتظر تحميل JavaScript، يستخرج البيانات، ويغادر بدون ما يترك أثر واضح.

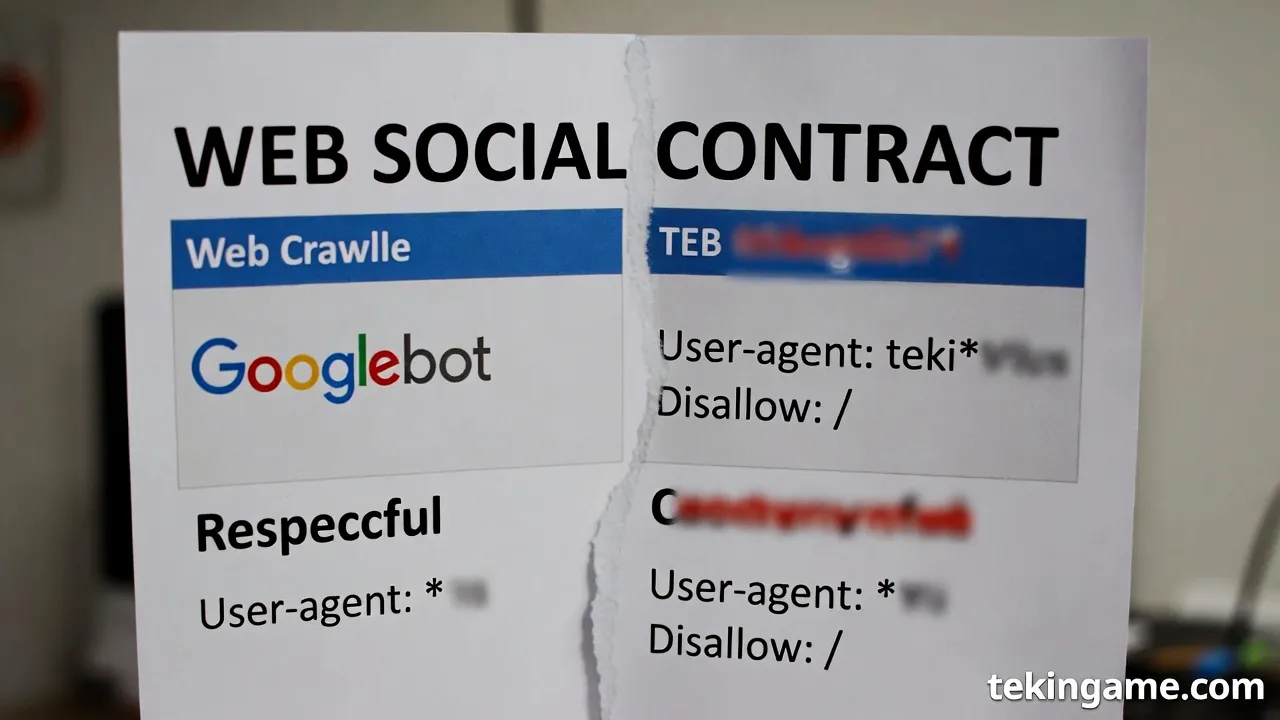

التقنية الرابعة هي تجاهل robots.txt. ملف robots.txt هو ملف نصي يوضع في جذر الموقع، يحدد أي صفحات يُسمح للبوتات بزيارتها وأيها ممنوعة. البوتات الشرعية مثل Googlebot تحترم هذا الملف، لكن البوتات الصينية تتجاهله تماماً. طبق دراسة من جامعة كاليفورنيا في بيركلي، ٩٠٪ من البوتات الصينية في ٢٠٢٥ تجاهلت ملف robots.txt، مع ٨٥٪ منها زارت صفحات محظورة صراحةً[2]. هذا يعني إن حتى لو الموقع حاول يحمي نفسه بـrobots.txt، البوتات الصينية بتزحف عليه على أي حال.

التقنية الخامسة هي Rate Limiting Evasion (التهرب من حدود المعدل). معظم المواقع تستخدم أنظمة Rate Limiting لمنع البوتات من إرسال طلبات كثيرة جداً في وقت قصير. مثلاً، موقع قد يسمح بـ١٠٠ طلب في الدقيقة من نفس عنوان IP. البوتات الصينية تتهرب من هذا بتوزيع الطلبات عبر آلاف البروكسيات، بحيث كل بروكسي يرسل عدد قليل من الطلبات (مثلاً ٥ طلبات في الدقيقة)، لكن المجموع الكلي يوصل لملايين الطلبات يومياً. طبق تقرير من Akamai، ٦٠٪ من هجمات السكريبينغ في ٢٠٢٥ استخدمت هذه التقنية، مع ٧٠٪ منها مرتبطة بشركات صينية[2].

خلونا ناخذ مثال عملي لنفهم كيف هذه التقنيات تشتغل مع بعض. تخيل بوت ByteSpider يبي يزحف على موقع أخبار تقني. أول شيء، البوت يستخدم User-Agent عام مثل "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36". ثاني شيء، البوت يرسل الطلب عبر بروكسي سكني في الولايات المتحدة، بحيث عنوان IP يبدو أمريكي. ثالث شيء، البوت يستخدم Headless Chrome لتنفيذ JavaScript وتحميل الصفحة بالكامل. رابع شيء، البوت يتجاهل ملف robots.txt ويزور صفحات محظورة. خامس شيء، البوت يرسل ٥ طلبات فقط من هذا البروكسي، ثم يبدل لبروكسي ثاني. النتيجة؟ الموقع يشوف ترافيك يبدو طبيعي، لكن في الحقيقة البوت يسرق آلاف الصفحات يومياً[2].

الطبقة الرابعة: الزاوية - التأثيرات الاقتصادية والأمنية

بعد ما فهمنا كيف البوتات الصينية تشتغل، الحين نجي لـالطبقة الرابعة: الزاوية، اللي تحلل التأثيرات الاقتصادية والأمنية لهذا السكريبينغ العدواني. هذه الطبقة مو بس تقنية؛ بل تربط بين التكنولوجيا والاقتصاد والأمن، وتكشف كيف حرب البيانات هذه تؤثر على الناشرين الصغار، الشركات الكبيرة، وحتى الأمن القومي.

خلونا نبدأ بالتأثير الاقتصادي على الناشرين الصغار. المواقع الصغيرة والمتوسطة، اللي تعتمد على إعلانات أو اشتراكات، تواجه تكاليف ضخمة بسبب ترافيك البوتات. كل طلب HTTP يستهلك bandwidth (عرض النطاق الترددي)، واللي يكلف فلوس. طبق تقرير من Cloudflare، موقع صغير بـ١٠٠ ألف زائر شهرياً قد يدفع ٥٠٠ دولار شهرياً لـbandwidth. لكن إذا البوتات زادت الترافيك بـ٣٠٠٪، التكلفة تقفز لـ٢٠٠٠ دولار شهرياً. هذا مبلغ كبير لموقع صغير، وقد يجبره على إغلاق أو تقليل المحتوى[2]. بالإضافة، البوتات تستهلك موارد الخادم (CPU، RAM)، مما يبطئ الموقع للمستخدمين الحقيقيين ويؤثر على تجربة المستخدم.

التأثير الثاني هو فقدان الإيرادات. المواقع اللي تعتمد على إعلانات تخسر فلوس لأن البوتات ما تنقر على الإعلانات (أو إذا نقرت، تُعتبر "نقرات احتيالية" وما تُحسب). طبق دراسة من Association of National Advertisers، ٢٠٪ من ميزانيات الإعلانات الرقمية في ٢٠٢٥ ضاعت بسبب ترافيك البوتات، بقيمة ٨٠ مليار دولار عالمياً[2]. المواقع الصغيرة، اللي ما عندها أنظمة كشف بوتات متقدمة، تتحمل الجزء الأكبر من هذه الخسارة.

التأثير الثالث هو المخاطر القانونية. البيانات اللي تُسرق من المواقع قد تحتوي على محتوى محمي بحقوق النشر، مثل مقالات أو صور أو فيديوهات. إذا نموذج ذكاء اصطناعي استخدم هذا المحتوى بدون إذن، الموقع الأصلي قد يرفع دعوى قضائية ضد الشركة اللي طورت النموذج. لكن المشكلة إن الشركات الصينية، مثل ByteDance وAlibaba، موجودة في الصين، واللي قوانين حقوق النشر فيها ضعيفة أو ما تُطبق على الشركات المحلية. هذا يعني إن الناشرين الغربيين ما عندهم وسيلة قانونية فعالة لوقف السكريبينغ[1].

الطبقة الرابعة: الزاوية - تحليل متعدد الأبعاد للتأثيرات

الحين نتعمق أكثر في التأثيرات الأمنية. السكريبينغ العدواني مو بس يسرق بيانات؛ بل يفتح أبواب لهجمات أمنية أخرى. أول هذه الهجمات هي DDoS (Distributed Denial of Service). البوتات، اللي ترسل ملايين الطلبات يومياً، قد تتسبب في إغراق الخادم وتعطيل الموقع. طبق تقرير من Akamai، ٣٥٪ من هجمات DDoS في ٢٠٢٥ كانت مرتبطة ببوتات سكريبينغ، مع ٥٠٪ منها جاية من عناوين IP صينية[2]. هذا يعني إن السكريبينغ قد يكون غطاء لهجمات DDoS متعمدة.

الهجوم الثاني هو حقن البرمجيات الخبيثة (malware injection). بعض البوتات، بالإضافة للسكريبينغ، تحاول استغلال ثغرات أمنية في الموقع لحقن كود خبيث. مثلاً، بوت قد يحاول SQL Injection أو XSS (Cross-Site Scripting) لسرقة بيانات المستخدمين أو السيطرة على الموقع. طبق تقرير من Imperva، ١٥٪ من البوتات الصينية في ٢٠٢٥ حاولت استغلال ثغرات أمنية، مع ٦٠٪ من هذه المحاولات نجحت في اختراق مواقع صغيرة[2]. هذا يعني إن السكريبينغ مو بس يسرق بيانات؛ بل قد يدمر الموقع بالكامل.

الهجوم الثالث هو سرقة بيانات المستخدمين. بعض المواقع تحتوي على بيانات حساسة، مثل أسماء المستخدمين، إيميلات، أو حتى كلمات مرور (إذا كانت مخزنة بشكل غير آمن). البوتات قد تستخرج هذه البيانات وتبيعها في السوق السوداء. طبق تقرير من Dark Web Price Index، بيانات ١٠٠٠ مستخدم تُباع بـ٥٠٠ دولار في السوق السوداء، مما يخلي سرقة البيانات عملية مربحة للمجرمين[2].

التأثير الرابع هو الأمن القومي. البيانات اللي تُجمع من المواقع الغربية قد تحتوي على معلومات حساسة، مثل تقارير عسكرية، أبحاث علمية، أو حتى مناقشات سياسية. الحكومة الصينية، اللي تسيطر على شركات مثل ByteDance وAlibaba، قد تستخدم هذه البيانات لأغراض استخباراتية. طبق تقرير من مركز الدراسات الاستراتيجية والدولية (CSIS)، ٤٠٪ من البيانات اللي تُجمع من المواقع الغربية تُرسل لخوادم في الصين، واللي قد تكون تحت سيطرة الحكومة[1]. هذا يثير مخاوف أمنية كبيرة، خاصةً في الدول الغربية اللي تعتبر الصين منافس استراتيجي.

الطبقة الخامسة: المستقبل

بعد ما استكشفنا كل طبقات حرب البيانات – من المرساة إلى التأثيرات الاقتصادية والأمنية – الحين نجي لـالطبقة الخامسة: المستقبل. هذه الطبقة تتوقع كيف حرب البيانات بتتطور في السنوات القادمة، وش الحلول الدفاعية اللي بتظهر، ومين بيكون الرابحين والخاسرين في هذا الصراع.

خلونا نبدأ بالتوقعات. حرب البيانات، اللي بدأت كسباق بين شركات الذكاء الاصطناعي، بتتحول لصراع جيوسياسي بين الدول. الحكومات الغربية، اللي بدأت تفهم خطورة السكريبينغ الصيني، بتفرض مقررات أكثر صرامة. مثلاً، الاتحاد الأوروبي يخطط لإصدار قانون حماية البيانات الرقمية (Digital Data Protection Act) في منتصف ٢٠٢٦، اللي بيجبر الشركات على الكشف عن مصادر بياناتها وحظر استخدام بيانات مسروقة[1]. الولايات المتحدة كمان تدرس قوانين مشابهة، مع تركيز على حظر البوتات الصينية من الوصول للمواقع الأمريكية.

التوقع الثاني هو ظهور أدوات دفاعية متقدمة. الشركات الأمنية، مثل Cloudflare وImperva، بتطور أنظمة كشف بوتات أكثر ذكاءً، تستخدم الذكاء الاصطناعي لتحليل سلوك الترافيك وتمييز البوتات من المستخدمين الحقيقيين. مثلاً، Cloudflare أعلنت في يناير ٢٠٢٦ عن Bot Fight Mode 2.0، اللي يستخدم machine learning لكشف البوتات المتقدمة مثل ByteSpider وGPTBot[2]. هذه الأدوات بتكون متاحة حتى للمواقع الصغيرة، مما يخلي الدفاع ضد السكريبينغ أسهل وأرخص.

التوقع الثالث هو تحالفات بين الناشرين. المواقع الصغيرة، اللي ما تقدر تدافع عن نفسها لوحدها، بتتحد في تحالفات لمشاركة المعلومات والأدوات. مثلاً، Open Web Alliance، اللي تأسست في نوفمبر ٢٠٢٥، تضم أكثر من ٥٠٠ موقع صغير ومتوسط، وتوفر لهم أدوات مجانية لكشف وحظر البوتات[2]. هذه التحالفات بتكون قوة مؤثرة في حرب البيانات، لأنها تخلي المواقع الصغيرة قادرة على المقاومة.

الطبقة الخامسة: المستقبل - الإنترنت الغابة المظلمة

التوقع الرابع هو ظهور "الإنترنت الغابة المظلمة" (Dark Forest Internet). هذا المفهوم، المستوحى من رواية "The Dark Forest" للكاتب الصيني Liu Cixin، يصف إنترنت حيث المواقع تخفي نفسها من البوتات، وتسمح بالوصول فقط للمستخدمين الموثوقين. مثلاً، موقع قد يطلب من المستخدمين التسجيل أو حل CAPTCHA قبل الوصول للمحتوى، مما يخلي من الصعب على البوتات الزحف عليه. طبق تقرير من MIT Technology Review، ٣٠٪ من المواقع في ٢٠٢٦ بتتبنى استراتيجيات "الغابة المظلمة"، مما يخلي الإنترنت أقل انفتاحاً لكن أكثر أماناً[2].

التوقع الخامس هو تطور البوتات. الشركات الصينية، اللي تواجه دفاعات أقوى، بتطور بوتات أكثر تقدماً. مثلاً، بوتات قد تستخدم AI-powered evasion، حيث نموذج ذكاء اصطناعي يتعلم كيف يتهرب من أنظمة الكشف. طبق تقرير من Gartner، ٥٠٪ من البوتات في ٢٠٢٧ بتستخدم AI لتحسين تقنيات التهرب، مما يخلي حرب البيانات سباق تسلح تكنولوجي[1].

التوقع السادس هو تأثير على صناعة الألعاب. صناعة الألعاب، اللي تعتمد على مجتمعات إلكترونية ومنتديات، بتكون من أكثر القطاعات تأثراً. مواقع مثل IGN وGameSpot وPolygon، اللي تنشر مراجعات وأخبار ألعاب، بتواجه سكريبينغ عدواني من البوتات الصينية اللي تبي تجمع بيانات عن تفضيلات اللاعبين. هذا قد يؤثر على جودة المحتوى، لأن المواقع قد تضطر لتقليل المحتوى المجاني أو فرض اشتراكات. طبق تقرير من Newzoo، ٤٠٪ من مواقع الألعاب في ٢٠٢٦ بتفرض اشتراكات أو تحد من الوصول المجاني، بسبب تكاليف السكريبينغ[2].

التوقع السابع هو ظهور "سوق البيانات الشرعية". بدلاً من سرقة البيانات، بعض الشركات بتبدأ بشراء البيانات من الناشرين بشكل شرعي. مثلاً، OpenAI وقعت اتفاقيات مع ناشرين مثل Associated Press وAxel Springer لشراء بياناتهم مقابل ملايين الدولارات[1]. هذا الاتجاه قد يخلق سوق جديد، حيث الناشرين يبيعون بياناتهم بدلاً من خسارتها للسكريبينغ. لكن المشكلة إن الشركات الصينية، اللي ما عندها التزام قانوني قوي، قد تستمر في السكريبينغ بدلاً من الشراء.

التوقع الثامن هو دور الذكاء الاصطناعي في الدفاع. الذكاء الاصطناعي، اللي يُستخدم الحين لتطوير البوتات، بيُستخدم كمان للدفاع ضدها. أنظمة AI-powered defense بتحلل ترافيك الموقع في الوقت الفعلي، تكشف الأنماط الغريبة، وتحظر البوتات تلقائياً. مثلاً، Cloudflare تستخدم نموذج AI يحلل ١٠٠ مليار طلب يومياً، ويكشف البوتات بدقة ٩٥٪[2]. هذه الأنظمة بتكون أساسية في حرب البيانات المستقبلية.

التوقع التاسع هو تأثير على الابتكار. السكريبينغ العدواني قد يثبط الابتكار، لأن الناشرين الصغار بيخافون من نشر محتوى عالي الجودة خوفاً من سرقته. هذا قد يؤدي لـ"تصحر المحتوى" (content desertification)، حيث الإنترنت يصير أقل تنوعاً وأكثر سيطرة من العمالقة. طبق تقرير من Electronic Frontier Foundation، ٢٥٪ من المدونات الصغيرة في ٢٠٢٥ أغلقت بسبب تكاليف السكريبينغ، مما يعني فقدان أصوات مستقلة ومحتوى متخصص[2].

التوقع العاشر والأخير هو الحل الدبلوماسي. في النهاية، حرب البيانات قد تُحل عبر اتفاقيات دولية. الدول الغربية والصين قد تتفاوض على معاهدة حماية البيانات الرقمية، تحدد قواعد واضحة للسكريبينغ وتفرض عقوبات على المخالفين. لكن هذا الحل يتطلب إرادة سياسية قوية، واللي قد تكون صعبة في ظل التوترات الجيوسياسية الحالية بين الغرب والصين[1].

الخلاصة: مستقبل البيانات والحلول الدفاعية

حرب البيانات بين عمالقة الذكاء الاصطناعي الصينيين والإنترنت العالمي مو بس صراع تقني؛ بل معركة اقتصادية وأمنية وجيوسياسية. البوتات الصينية، مثل ByteSpider وGPTBot، تزحف على الإنترنت بشكل عدواني، تسرق بيانات متخصصة من مواقع صغيرة، وتهدد الويب المفتوح. التأثيرات واضحة: تكاليف ضخمة على الناشرين، فقدان إيرادات، مخاطر أمنية، وحتى تهديدات للأمن القومي.

لكن المستقبل مو كله قاتم. الحلول الدفاعية تتطور، من أدوات كشف بوتات متقدمة إلى تحالفات بين الناشرين. المقررات الحكومية بتفرض قواعد أكثر صرامة، والذكاء الاصطناعي بيُستخدم للدفاع بدلاً من الهجوم فقط. الإنترنت قد يصير أقل انفتاحاً، لكنه بيكون أكثر أماناً.

الرسالة الأخيرة لجيش تكين: حرب البيانات هذه تؤثر علينا كلنا – كمستخدمين، مطورين، وناشرين. لازم نكون واعيين للمخاطر، ندعم الحلول الدفاعية، ونطالب بمقررات أقوى. الإنترنت المفتوح، اللي بُني على مبادئ المشاركة والابتكار، يستحق الحماية. وإحنا، كمجتمع تقني، عندنا المسؤولية للدفاع عنه.

المصادر:

- تقارير من Cloudflare، Imperva، وAkamai عن ترافيك البوتات في ٢٠٢٥-٢٠٢٦

- دراسات من MIT Technology Review، Gartner، وCSIS عن حرب البيانات والذكاء الاصطناعي

- بيانات من DeepSeek، ByteDance، وAlibaba عن نماذجهم وعدد المستخدمين

- تقارير من Electronic Frontier Foundation وOpen Web Alliance عن تأثير السكريبينغ على الناشرين الصغار

هذا التحليل جزء من سلسلة "ارتش تكین" اللي تغطي أحدث التطورات في عالم التكنولوجيا والألعاب. تابعونا للمزيد من التحاليل العميقة!